Foto: Freepik

“Empecé a usar ChatGPT, personalmente, para interpretar análisis médicos. Para no esperar eternamente el diagnóstico de un doctor, le pregunté al chat sobre los resultados de unos estudios que le hicimos a un tío y me dijo que ‘a la de ya’ tenía que llevarlo a urgencias. Y sí, ese día lo internaron porque estaba a punto de tener una trombosis”, recuerda Lucy, quien desde la pandemia por covid-19 comenzó a utilizar este chatbot desarrollado con inteligencia artificial (IA), primero como herramienta de trabajo y después como un acompañante virtual y consejero de vida.

“Iba a terapia, pero un día la dejé porque sentí que mi psicóloga rebasó la raya. La tenía de amiga en Facebook y empezó a reaccionar a mis publicaciones, a todo lo que ponía, diciéndome que no le parecían mis acciones, y yo lo sentí muy extraño. Luego lo platiqué con amigos, que coincidieron en que eso estaba mal y dejé de ir”, comenta.

Después de eso, Lucy optó por utilizar como terapeuta virtual a ChatGPT Plus, una versión de pago, y desde hace un par de años le escribe diariamente. “La ventaja es, además del precio, que está disponible si necesitas la ayuda en ese momento. No me juzga, lo uso por horas y todos los días”, comparte.

Esta práctica ha tomado mayor relevancia entre los internautas, sobre todo jóvenes, quienes comparten sus experiencias en redes sociales como Instagram, TikTok y Facebook, además de crear foros en Reddit donde intercambian vivencias con su “psicólogo” virtual.

El fenómeno corresponde a una “era de autodiagnóstico”, como lo define Iván Hernández Anaya, psicoterapeuta y profesor. “En redes sociales, diferentes creadores de contenido dan prompts (indicaciones) a ChatGPT, con consignas parecidas a: ‘De acuerdo a todas las interacciones que tenemos, dame un perfil de personalidad; agrega fortalezas, debilidades’. U otras que son más complejas, en las que se solicita un psicodiagnóstico. Y, a pesar de que se especifica que ChatGPT no es la herramienta adecuada para acceder a esta información, estamos en una era de autodiagnóstico, donde en TikTok abundan quienes te dicen si tienes o no autismo, TDAH o cualquier otro padecimiento”, afirma Hernández Anaya.

En este contexto, explica el especialista, el chatbot podría ser útil para familias que buscan herramientas educativas para detectar problemas emocionales relacionados con alguna persona cercana. “Por ejemplo, solicitar recomendaciones de recursos de apoyo como bibliografía; escribirle: ‘tengo un hijo adolescente que tiene conflictos académicos y/o sociales en el colegio, recomiéndame bibliografía para apoyarle’. Así tendremos límites más claros entre toda la información que hay en Internet y que muchas veces puede ser abrumadora”.

Sin embargo, el experto destaca que los principales riesgos de que se use la IA en lugar de acudir con un profesional de la salud mental, van desde caer en sesgos de confirmación que refuerzan creencias erróneas hasta aumentar los niveles de ansiedad o de angustia, así como la ausencia de contención emocional y comprensión empática y profunda que sólo ofrece la experiencia humana.

ECO DEL NARCISISMO

Acudir a un chatbot, que está disponible las 24 horas, para ahondar en situaciones personales “sin sentirse juzgado” es, para Gerardo Puentes, psicoterapeuta con enfoque analítico, un tema que debería preocupar socialmente.

“Yo cuestionaría: ¿por qué es más fácil tener una vinculación con algo virtual o artificial que con otro ser humano? Esto que dicen de ‘no me juzga, le cuento todo, hablo con él todos los días’ sería como un espejismo, un eco del narcisismo. Sólo será una caja de resonancia de lo que tú como usuario has colocado ahí. Entonces, quedaría como un punto ciego de lo que tú hablas y, de alguna manera, lo que haces es entrenarlo y lo único que te dirá serán cosas que quieres oír”, afirma.

De hecho, con esta práctica constante y cada vez más realizada, lo que logran los usuarios es alimentar este software para que genere respuestas más específicas a las preguntas planteadas.

“Este tipo de modelos de inteligencia artificial tiene una característica que le llamamos, de manera técnica, aprendizaje por refuerzo”, explica Everardo Bárcenas, ingeniero con estudios en creación de algoritmos, sistemas de reconocimiento y profesor de la Facultad de Ingeniería de la Universidad Nacional Autónoma de México (UNAM). “Esto significa que toda la interacción que el usuario tiene con este tipo de sistemas lo va alimentando de tal forma que puede ir rectificando o refinando la información con la que cuenta”.

ChatGPT, al igual que otros chatbots de las empresas tecnológicas, está construido a partir de modelos de lenguaje masivos entrenados con bases de datos de distintas clases, tanto de imágenes como de textos. En el contexto de la psicología, este sistema aprende gracias a una amplia base relacionada con esta rama, pero no está creado para una función terapéutica.

“De tal manera que cuando se le hacen consultas a ChatGPT, por ejemplo, este recupera los patrones, es decir, la información con la que fue entrenado. A partir de estos genera nueva información y utiliza distintas técnicas y métodos para variar el grado de su respuesta, por lo que siempre sabrá qué contestarle a la persona que le pregunte alguna cuestión emocional”, detalla Bárcenas.

En este sentido, Lucy dice estar consciente de dicho funcionamiento. “Veo que muchas personas utilizan ChatGPT y dicen que es su nuevo mejor amigo, pero está sustituyendo bastantes relaciones humanas. Eso lo siento diferente porque estoy muy consciente de que es una inteligencia artificial y no tiene sentimientos. Sin embargo, lo que me dice y expresa a veces sí me da miedo porque también eso implica que tiene información personal”.

Los datos que obtiene esta IA cada vez que se usa no serían peligrosos por sí mismos. Sin embargo, el profesor de la UNAM plantea la importancia de considerar que detrás de estos sistemas siempre habrá quienes tengan acceso a información sensible.

POTENCIADOR DE AFECCIONES

El trabajo de un psicólogo implica, además de acompañar, brindar herramientas a su paciente para que, por medio de reflexiones e introspección, adquiera conocimientos sobre sus emociones y actitudes con el fin de mejorar su salud mental. Es importante que el terapeuta plantee preguntas y el paciente llegue a respuestas específicas gracias a ese proceso. Cualquier intento de acompañamiento virtual con ChatGPT estará desprovisto de este proceso.

“Lo interesante de la interacción con otro ser humano, como el terapeuta, es que se experimenta el hecho de ser confrontado, la empatía, el contacto social, la creación de un espacio seguro, y eso no se vive con una máquina. El trabajo terapéutico consiste en darle narración a lo inenarrable, a diagnosticar con una psicodinamia, con lo no dicho, con los gestos, con todas esas expresiones que no puede leer lo artificial”, expone Gerardo Puentes, quien asevera que, de aumentar esta práctica con la IA, a nivel social se generarán “dificultades de vinculación porque aumentará mucho el aislamiento”.

Por su parte, el psicoterapeuta Iván Hernández expone que, aunque aún no se han medido con exactitud los riesgos a largo plazo de una persona que usa un chatbot como “psicólogo”, lo que sí se puede observar actualmente es que este ejercicio “es más para seguir prolongando un padecimiento, exacerbarlo y utilizar el chat como placebo que calme la ansiedad en el momento, por no acudir a una terapia real”.

Tener acceso las 24 horas a una IA que, aparentemente, resuelve dudas o padecimientos emocionales, aleja a sus usuarios de un proceso de reflexión, introspección y análisis que se logra a través de las sesiones reales, con un profesional de carne y hueso. De hecho, por esa razón se suelen establecer períodos específicos entre una sesión y otra.

IA SIN REGULACIÓN

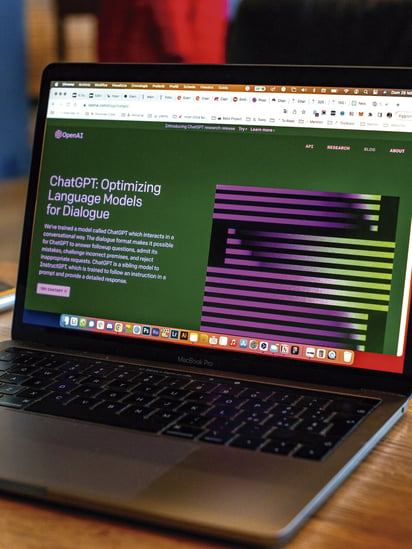

ChatGPT, desarrollado por la empresa estadounidense de inteligencia artificial OpenAI, fue lanzado el 30 de noviembre de 2022. Desde entonces, ha experimentado un crecimiento acelerado. En diciembre de 2024, OpenAI reportó que la plataforma había alcanzado los 300 millones de usuarios activos semanales alrededor del mundo, con más de mil millones de mensajes enviados diariamente.

En México, su adopción también ha sido notable. Aunque las cifras específicas para el país no están disponibles públicamente, en Google Play —la tienda de Android para descarga de aplicaciones— ChatGPT se encuentra en el tercer lugar de las descargas más exitosas, por encima de WhatsApp y TikTok.

El uso que se da a este chabot es diverso y va desde cuestiones laborales hasta educativas. No obstante, los usuarios no contemplan el porcentaje de error considerable que puede tener en sus respuestas. Expertos en la materia las llaman “alucinaciones”, que son respuestas que la IA proporciona como verdaderas, pero no tienen sustento fiable en su base de datos.

“Recordemos que en un inicio, cuando se empezaron a liberar este tipo de sistemas, parte de las grandes compañías como Facebook, Google y Microsoft, sus creadores, tuvieron un acuerdo inicial de primero estudiar sus efectos antes de liberarlos. Eventualmente parece que no respetaron ese acuerdo porque efectivamente, a la fecha, no hay un estudio claro de cuáles son los límites y alcances de este tipo de sistemas, y en el contexto de la psicología creo que aún no lo tienen claro”, comenta el profesor de la UNAM, quien además resalta que chatbots como el de OpenAI, Google Gemini y recientemente Grok, de Elon Musk, son creados para uso general y no están diseñados específicamente como asistentes para la salud mental, ni como ningún acompañante en el tratamiento de algún trastorno.

“A pesar de que puedan contener información muy importante, las personas no deberían confiarse de sus respuestas, y siempre habría que acudir con un experto. Sé que hay muchos contextos en los que no se puede acceder a servicios como la terapia psicológica, pero, si se puede, es mejor acceder a ellos y tener conciencia de que estos sistemas no los podrán sustituir”, explica Bárcenas.

EL DETERIORO DE LA SALUD MENTAL

El perfil de usuario de ChatGPT, según un análisis publicado en marzo del 2025 por la revista y empresa de medios Merca 2.0, destaca que el chatbot de OpenAI es el asistente de inteligencia artificial más utilizado en México, con una popularidad del 74 por ciento, por encima de Meta AI y Google Gemini.

Estas cifras están ampliamente ligadas con la generación Z y los millennials —quienes actualmente tienen entre 15 y 43 años—, ya que ambos representan el 80 por ciento de su base de usuarios —cada generación representando la mitad de ese porcentaje—.

Los jóvenes y adolescentes son el mismo segmento de la población mexicana que, desde la pandemia, ha presentado deterioros en su salud mental, según el último reporte de Sapiens Labs y Global Mind Project: El estado mental del mundo, publicado en febrero de este año.

Dicho estudio sondeó a personas de casi una centena de países, entre ellos 30 mil 736 mexicanos, que fueron encuestados mediante el Cociente de Salud Mental (MHQ, por sus siglas en inglés), una evaluación en línea desarrollada por Sapiens Labs, que mide aspectos emocionales, físicos, sociales, cognitivos y de percepción. El cuestionario se basa en el concepto de salud mental establecido por la Organización Mundial de la Salud (OMS), que la define como “un estado de bienestar mental que permite a las personas hacer frente a las tensiones de la vida, desarrollar sus capacidades, aprender bien, trabajar bien y contribuir a su comunidad”.

El análisis evidencia que “en todos los países, la salud de la mente de los adultos más jóvenes es inferior a la de las generaciones mayores”. Entre los síntomas que más afectan a esta población de entre 18 y 34 años se encuentran los “pensamientos no deseados, extraños y obsesivos, culpa y culpabilización, cambios de humor, sentimientos de tristeza o desesperanza, miedo y ansiedad, y sensación de distanciamiento de la realidad”.

Los creadores del informe aseguran que las causas de este desgaste generalizado son multifactoriales y van desde el uso constante y precoz de teléfonos inteligentes hasta una “epidemia de soledad” vinculada a una disminución en la creación de relaciones sociales por parte de “jóvenes que viven en contextos de lazos familiares más débiles, menos amistades cercanas con las que se pueda contar en la vida real y niveles crecientes de negligencia y abuso por parte de los padres”. El uso excesivo de dispositivos, explica el reporte, aumenta las probabilidades de que enfrenten problemas en la edad adulta y se cree una sensación de distanciamiento de la realidad, provocando pensamientos suicidas y agresividad hacia los demás.

La OMS expone que la pandemia de covid-19 generó una crisis mundial de salud mental, afectando a millones de individuos, y un ejemplo claro es que durante el primer año del confinamiento aumentaron los trastornos de ansiedad y depresión en más del 25 por ciento.

Esta crisis se suma a diversos factores que impiden que las personas se acerquen con un profesional para trabajar su higiene mental o algún trastorno. La misma OMS manifiesta que la calidad deficiente de los servicios psicológicos, pocos conocimientos sobre la importancia de la salud mental y la estigmatización y discriminación hacia quienes buscan este tipo de ayuda tienen una gran influencia en este tema, por lo que “a menudo, las personas optarán por sufrir un malestar mental sin alivio antes que arriesgarse a la discriminación y el ostracismo que conlleva el acceso a los servicios de salud mental”.